В век Интернета существуют терабайты и петабайты данных, и при этом экспоненциальный рост. Но как мы используем эти данные и преобразовываем их в полезную информацию для повышения доступности услуг?

Достоверные, новые и понятные данные — это все, что нужно бизнесу для их моделей поиска знаний.

По этой причине предприятия применяют аналитику разными способами для получения качественных данных.

Но с чего все начинается? Ответ — споры с данными.

Давайте начнем!

Оглавление

Что такое обработка данных?

Обработка данных — это процесс очистки, структурирования и преобразования необработанных данных в форматы, упрощающие процессы анализа данных. Обработка данных часто связана с работой с беспорядочными и сложными наборами данных, которые не готовы для процессов конвейера данных. Обработка данных переводит необработанные данные в уточненное состояние или уточненные данные в оптимизированное состояние и на уровень готовности к производству.

Некоторые из известных задач обработки данных включают в себя:

- Объединение нескольких наборов данных в один большой набор данных для анализа.

- Изучение отсутствующих/пробелов в данных.

- Удаление выбросов или аномалий в наборах данных.

- Стандартизация входных данных.

Большие хранилища данных, задействованные в процессах обработки данных, обычно не поддаются ручной настройке, что требует автоматизированных методов подготовки данных для получения более точных и качественных данных.

Цели обработки данных

Помимо подготовки данных для анализа в качестве более крупной цели, другие цели включают в себя:

- Создание достоверных и новых данных из беспорядочных данных для принятия решений в бизнесе.

- Стандартизация необработанных данных в форматы, которые могут принимать системы больших данных.

- Сокращение времени, затрачиваемого аналитиками данных на создание моделей данных, путем представления упорядоченных данных.

- Обеспечение согласованности, полноты, удобства использования и безопасности для любого набора данных, используемого или хранимого в хранилище данных.

Общие подходы к обработке данных

Открытие

Прежде чем инженеры данных приступают к задачам подготовки данных, им необходимо понять, как они хранятся, размер, какие записи хранятся, форматы кодирования и другие атрибуты, описывающие любой набор данных.

Структурирование

Этот процесс включает в себя организацию данных в удобном для использования формате. Для необработанных наборов данных может потребоваться структурирование отображения столбцов, количества строк и настройка других атрибутов данных для упрощения анализа.

Уборка

Структурированные наборы данных должны быть избавлены от внутренних ошибок и всего, что может исказить данные внутри. Таким образом, очистка влечет за собой удаление нескольких записей ячеек с похожими данными, удаление пустых ячеек и данных с выбросами, стандартизацию входных данных, переименование запутанных атрибутов и многое другое.

Обогащение

После того, как данные прошли этапы структурирования и очистки, необходимо оценить полезность данных и дополнить их значениями из других наборов данных, которых не хватает для обеспечения желаемого качества данных.

Проверка

Процесс проверки включает в себя аспекты итеративного программирования, которые проливают свет на качество данных, согласованность, удобство использования и безопасность. Этап проверки обеспечивает выполнение всех задач преобразования и помечает наборы данных как готовые к этапам анализа и моделирования.

Представление

После того, как все этапы пройдены, оспариваемые наборы данных представляются/распространяются внутри организации для аналитики. На этом этапе также предоставляется документация по этапам подготовки и метаданные, созданные в процессе спора.

Таленд

Таленд — это унифицированная платформа управления данными, заключенная в 3 структуры данных для предоставления надежных и надежных данных. Talend представляет интеграцию данных, приложения и интеграцию, а также целостность данных и управление. Обработка данных в Talend осуществляется с помощью браузерного инструмента «укажи и щелкни», который позволяет выполнять пакетную, массовую и оперативную подготовку данных — профилирование, очистку и документирование данных.

Talend Data Fabric обрабатывает каждый этап жизненного цикла данных, тщательно балансируя доступность данных, удобство использования, безопасность и целостность всех бизнес-данных.

Вы когда-нибудь беспокоились о своих разнообразных источниках данных? Унифицированный подход Talend обеспечивает быструю интеграцию данных из всех ваших источников данных (базы данных, облачные хранилища и конечные точки API), позволяя преобразовывать и отображать все данные с беспрепятственной проверкой качества.

Интеграция данных в Talend осуществляется с помощью инструментов самообслуживания, таких как соединители, которые позволяют разработчикам автоматически получать данные из любого источника и соответствующим образом классифицировать данные.

Особенности Talend

Универсальная интеграция данных

Talend позволяет компаниям обрабатывать данные любого типа из различных источников данных — облачных или локальных сред.

Гибкий

Talend выходит за рамки поставщика или платформы при создании конвейеров данных из ваших интегрированных данных. После того, как вы создадите конвейеры данных из полученных данных, Talend позволит вам запускать конвейеры где угодно.

Качество данных

Благодаря возможностям машинного обучения, таким как дедупликация данных, проверка и стандартизация, Talend автоматически очищает полученные данные.

Поддержка интеграции приложений и API

После того, как ваши данные будут осмыслены с помощью инструментов самообслуживания Talend, вы сможете поделиться своими данными с помощью удобных API. Конечные точки API Talend могут предоставлять ваши активы данных платформам SaaS, JSON, AVRO и B2B с помощью расширенных инструментов сопоставления и преобразования данных.

р

р — это хорошо разработанный и эффективный язык программирования для исследовательского анализа данных в научных и бизнес-приложениях.

Созданный как бесплатное программное обеспечение для статистических вычислений и графики, R является одновременно языком и средой для обработки данных, моделирования и визуализации. Среда R предоставляет набор программных пакетов, а язык R объединяет ряд статистических, кластерных, классификационных, аналитических и графических методов, помогающих манипулировать данными.

Особенности R

Богатый набор пакетов

Инженеры данных могут выбрать более 10 000 стандартных пакетов и расширений из комплексной сети архивов R (CRAN). Это упрощает споры и анализ данных.

Чрезвычайно мощный

Благодаря доступным пакетам распределенных вычислений R может выполнять сложные и простые манипуляции (математические и статистические) с объектами данных и наборами данных за считанные секунды.

Кроссплатформенная поддержка

R не зависит от платформы и может работать во многих операционных системах. Он также совместим с другими языками программирования, которые помогают выполнять сложные вычислительные задачи.

Изучить R легко.

Трифакта

Трифакта — это интерактивная облачная среда для профилирования данных, которые обрабатываются в соответствии с моделями машинного обучения и аналитики. Этот инструмент обработки данных предназначен для создания понятных данных независимо от того, насколько запутаны или сложны наборы данных. Пользователи могут удалять двойные записи и заполнять пустые ячейки в наборах данных с помощью дедупликации и преобразований линейного преобразования.

Этот инструмент обработки данных отслеживает выбросы и недействительные данные в любом наборе данных. Одним нажатием и перетаскиванием имеющиеся данные ранжируются и интеллектуально преобразуются с использованием предложений, основанных на машинном обучении, для ускорения подготовки данных.

Обработка данных в Trifacta осуществляется с помощью привлекательных визуальных профилей, которые могут вместить нетехнический и технический персонал. Благодаря визуализированным и интеллектуальным преобразованиям Trifacta гордится своим дизайном, ориентированным на пользователей.

При получении данных из киосков данных, хранилищ данных или озер данных пользователи защищены от сложностей подготовки данных.

Особенности Трифакты

Полная облачная интеграция

Поддерживает подготовительные рабочие нагрузки в любой облачной или гибридной среде, позволяя разработчикам получать наборы данных для обработки, где бы они ни находились.

Несколько методов стандартизации данных

Trifacta wrangler имеет несколько механизмов для выявления закономерностей в данных и стандартизации выходных данных. Инженеры данных могут выбрать стандартизацию по образцу, по функции или смешивать и сочетать.

Простой рабочий процесс

Trifacta организует работу по подготовке данных в виде потоков. Поток содержит один или несколько наборов данных, а также связанные с ними рецепты (определенные шаги, преобразующие данные).

Таким образом, поток сокращает время, затрачиваемое разработчиками на импорт, обработку, профилирование и экспорт данных.

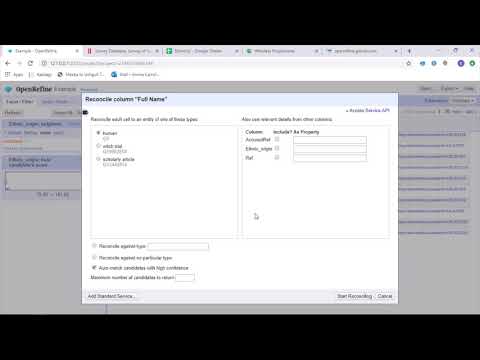

OpenRefine

OpenRefine — это зрелый инструмент с открытым исходным кодом для работы с беспорядочными данными. Как инструмент очистки данных, OpenRefine исследует наборы данных за считанные секунды, применяя сложные преобразования ячеек для представления желаемых форматов данных.

OpenRefine подходит к обработке данных с помощью фильтров и разделов в наборах данных с использованием регулярных выражений. Используя встроенный язык выражений General Refine Expression, инженеры данных могут изучать и просматривать данные, используя фасеты, фильтры и методы сортировки, прежде чем выполнять расширенные операции с данными для извлечения сущностей.

OpenRefine позволяет пользователям работать с данными в виде проектов, в которых наборы данных из нескольких компьютерных файлов, веб-адресов и баз данных могут быть загружены в такие проекты с возможностью запуска локально на компьютерах пользователей.

С помощью выражений разработчики могут расширить очистку и преобразование данных до таких задач, как разделение/объединение многозначных ячеек, настройка фасетов и выборка данных в столбцы с использованием внешних URL-адресов.

Возможности OpenRefine

Кроссплатформенный инструмент

OpenRefine создан для работы с операционными системами Windows, Mac и Linux через загружаемые установщики.

Богатый набор API

Включает OpenRefine API, API расширения данных, API согласования и другие API, поддерживающие взаимодействие пользователей с данными.

Датамир

Datameer — это инструмент преобразования данных SaaS, созданный для упрощения обработки и интеграции данных в процессе разработки программного обеспечения. Datameer позволяет извлекать, преобразовывать и загружать наборы данных в облачные хранилища данных, такие как Snowflake.

Этот инструмент обработки данных хорошо работает со стандартными форматами наборов данных, такими как CSV и JSON, позволяя инженерам импортировать данные в различных форматах для агрегирования.

Datameer предлагает документацию данных в виде каталога, глубокое профилирование данных и обнаружение для удовлетворения всех потребностей преобразования данных. Инструмент поддерживает подробный визуальный профиль данных, который позволяет пользователям отслеживать недопустимые, отсутствующие или выдающиеся поля и значения, а также общую форму данных.

Работая в масштабируемом хранилище данных, Datameer преобразует данные для значимой аналитики с помощью эффективных стеков данных и функций, подобных Excel.

Datameer представляет гибридный пользовательский интерфейс с кодом и без кода, который подходит для широких групп аналитиков данных, которые могут легко создавать сложные конвейеры ETL.

Особенности Датамира

Несколько пользовательских сред

Среды преобразования данных для нескольких человек — с низким кодом, кодом и гибридные, для поддержки технически подкованных и нетехнических людей.

Общие рабочие пространства

Datameer позволяет командам повторно использовать модели и совместно работать над ними для ускорения проектов.

Богатая документация данных

Datameer поддерживает как системную, так и пользовательскую документацию данных с помощью метаданных и описаний в стиле вики, тегов и комментариев.

Заключительные слова 👩🏫

Аналитика данных — это сложный процесс, который требует, чтобы данные были надлежащим образом организованы, чтобы делать значимые выводы и делать прогнозы. Инструменты обработки данных помогают форматировать большие объемы необработанных данных для выполнения расширенной аналитики. Выберите лучший инструмент, который соответствует вашим требованиям, и станьте профессионалом в области аналитики!

Вам может понравиться:

Лучшие инструменты CSV для преобразования, форматирования и проверки.